tempo di lettura 9′

Parlando di illusioni ottiche, uno dei miei esempi preferiti è quello del gorilla invisibile, targato Chabrin e Simons, guardatelo se non lo conoscete.

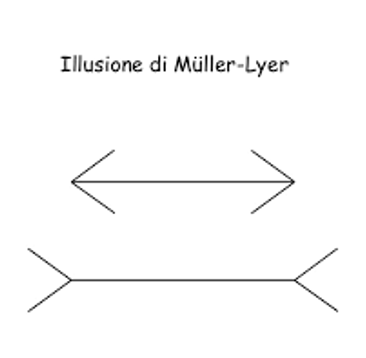

Altri esempi vanno dritti al punto non solo nonostante, ma proprio perché chiunque li ha già visti, e tutti sono al corrente del trucco che nascondono. Uno di questi è la cosiddetta illusione di Müller-Lyer. Non fate finta di non conoscerla: è quella in cui due segmenti, che ormai sappiamo tutti perfettamente essere di uguale lunghezza, ci appaiono diversi solo perché, ai loro estremi, sono state applicate punte di freccia orientate in senso opposto.

La sceneggiatura originale reciterebbe:

- “Qual è il segmento più lungo?”

- “Quello di sotto”

- “Falso: sono lunghi uguali”

- “Ma va là”

- “Prova a misurare con un righello!”

- “Incredibile, hai ragione!”

Ma siccome tutti conoscono l’illusione, il dialogo abortisce, e fallisce l’obiettivo iniziale –farci cadere in errore.

Ma solo perché siamo un po’ ipocriti. Un po’ di onestà intellettuale, infatti, ci farebbe riconoscere che col cavolo che li vediamo eguali. Sappiamo che lo sono, perché ci fidiamo di chi ce l’ha proposto, o perché abbiamo usato una tecnologia evoluta (il righello) per verificarlo. Ma la verità è che, se abbiamo una visione normale, non possiamo non continuare a vedere i due segmenti come ineludibilmente diversi.

Ciò che vediamo non coincide, in questo caso, con ciò che sappiamo.

Non ci stupiamo certo di essere anche noi vittime di questa innocua illusione ottica. Sono fenomeni universali, cui sono soggetti tutti coloro che sono dotati di un normale apparato percettivo (cervello incluso). Inoltre, ci meraviglieremmo se qualcuno vedesse, diversamente da noi, il segmento inferiore più corto dell’altro. Sono, in questo senso, illusioni sistematiche: producono errori che puntano sempre nella stessa direzione. Il che suggerisce che debbano essere l’effetto di qualche diavoleria comune a tutti i nostri apparati percettivi. Eppure, per quanto ci interroghiamo, non riusciamo a farci capaci di quale sia il meccanismo che ci ha indotto a vedere cose che non esistono. Anzi, se è per questo, non ci rendiamo neanche conto dell’esistenza di un simile meccanismo. Capiamo solo che si tratta di qualcosa di automatico, che passa al di sotto del livello della nostra coscienza. E, nonostante sappiamo di essere in errore, la nostra percezione continua a sembrarci inesorabilmente convincente.

Perché ci succede? Perché siamo fatti così. E perché siamo fatti in questo modo? Perché, in una prospettiva evoluzionistica, queste piccole distorsioni ci sono state di grande aiuto. Se il nostro cervello accettasse sempre a valore facciale ciò che registriamo sulla retina, ad esempio, avremmo seri problemi a decifrare il mondo che ci circonda. Il grattacielo sulla skyline della nostra città, che sulla retina ci appare della dimensione del nostro pollice, verrebbe percepito come un giocattolino. Fortunatamente una serie di processi mentali – euristiche della visione – entrano automaticamente in funzione e, insieme ad altri indizi, ci permettono di interpretare l’immagine come quella di un oggetto molto grande posto a distanza assai elevata. Nessuno di noi si accorge di usare un’euristica, e men che meno potrebbe spiegare come funziona. Eppure, nella quasi totalità dei casi, l’euristica funziona. Quasi sempre, ma non sempre. E, quella rara volta che finiamo tra le grinfie di uno psicologo che ha voglia di giocare, produce un errore.

Ma che c’entra un’illusione percettiva con i bias cognitivi? Fidatevi. Se non di me, di Daniel Kahneman, un Premio Nobel che ci rammenta che, oltre che in quelle percettive, siamo costantemente immersi in un fiume di illusioni cognitive.

La quantità di micro-valutazioni e micro-decisioni che siamo chiamati ad assumere in una giornata tipo è enorme. Dalla pressione da esercitare sull’acceleratore dell’auto, alla pianificazione della nostra agenda. Qualcuno ne ha valutato il numero nell’ordine delle decine di migliaia. Fatte salve otto ore di sonno, saremmo chiamati a una decisione ogni 16 secondi. Se dovessimo seguire le logiche della razionalità aurea per ciascuna di esse, non avremmo tempo per fare altro nella vita. Oltre che necessitare della potenza di calcolo di Deep Blue e della forza di volontà del Mahatma Gandhi, come suggeriva un altro Nobel, Richard Thaler. Pura logica di sopravvivenza, dunque, esige che, nel corso dell’evoluzione, noi umani abbiamo dovuto escogitare una grande quantità di scorciatoie, regole del pollice, da usare, almeno nella maggior parte dei casi, al posto delle procedure razionali. Delle euristiche, insomma. Obiettivo: risparmiare tempo, logorio mentale, e rottura di cabasisi.

Gli aspetti veramente notevoli della questione sono due.

- Primo: anche se talvolta ne usiamo qualcuna in modo consapevole e deliberato (ad esempio quando nell’acquisto di un cellulare scartiamo subito livelli di prezzo al di sopra o al di sotto di una certa fascia), in genere queste euristiche sono sepolte sotto il livello della nostra coscienza. Perché sono istinti trasmessi per via genetica, o risposte codificate dalla cultura in cui siamo cresciuti; o ancora regole che l’abitudine sposta dal faro della consapevolezza, e affida a una sorta di pilota automatico. Ad occuparsi della loro instancabile generazione è quello che Kahneman chiama pensiero veloce (o System 1): una componente della nostra mente che opera automaticamente, rapidamente, e senza pause. E, soprattutto, all’oscuro di quella parte del sistema legata alla volontarietà, alla riflessione, e al ragionamento cosciente (pensiero lento, o System 2). Che, dunque, non si accorge se un’euristica è stata attivata, e non è, a maggior ragione, in grado di valutare la bontà dei suoi contenuti.

- Il secondo aspetto è per me particolarmente sorprendente. Questi automatismi funzionano egregiamente. Sono numerosi, ben adattati al nostro quotidiano, in grado di prevedere abbastanza bene l’immediato futuro. Almeno nella maggior parte dei casi. In realtà non dovremmo essere così sorpresi. Data la loro onnipresenza, se così non fosse, presumibilmente saremmo ormai estinti da quel dì. E in effetti metterle in discussione non è certo tra i nostri sport preferiti. Ma, come per tutte le regole del pollice, esistono alcuni casi in cui esse non funzionano. E qui, come nelle illusioni percettive, arriva l’errore. Inaspettato, invisibile, ma inesorabile. Chiamiamo questo errore bias cognitivi.

I bias cognitivi condividono con l’illusione di Müller-Lyer diverse caratteristiche. Sono universali, vale a dire che ci caschiamo tutti. Inclusi coloro che li studiano professionalmente. C’è di buono, tuttavia, che non sono random. Puntano tutti nella stessa direzione. Possiedono dunque un elemento di sistematicità, che ci permette di considerarli in qualche misura prevedibili. Una caratteristica che ci servirà nel seguito.

Purtroppo, come abbiamo capito, hanno anche la peculiarità di essere invisibili alla nostra coscienza. Non ci accorgiamo di averli commessi. Peggio: anche se ci fanno notare di esserne stati vittime, continuiamo a vederli come giudizi o scelte di buon senso. Come seguitiamo a vedere i segmenti di Müller-Lyers come uguali, così continuiamo a percepire i nostri bias come, tutto sommato, ragionevoli. Sono lupi, ma vanno in giro travestiti da agnelli.

Ora: se, come si è detto, queste euristiche sono prodotte essenzialmente al di fuori dal nostro controllo, e se neanche ci accorgiamo di attivarle, come facciamo a difenderci dagli errori (i bias) che si generano quando le usiamo nel contesto sbagliato? È il problema del de-biasing, di come evitare di commetterli. Il che, come potete immaginare, ha un’importanza enorme, tanto dal punto di vista teorico, quanto nella nostra pratica di tutti i giorni.

La prima notizia non è confortante. Se è vero che il System 1 (quello automatico) opera automaticamente, e non possiamo spegnerlo a comando – impedirgli di sparare i suoi suggerimenti a casaccio – possiamo aspettarci che esso produca una discreta quantità di errori. L’unico filtro in grado di intercettarli può venire soltanto dal System 2 (quello riflessivo). In molti casi, tuttavia, non abbiamo nessun indizio di errore cui questo possa aggrapparsi. E, anche in presenza di segnali, non sarebbe uno stile di vita entusiasmante dedicare tutte le nostre risorse coscienti a una continua attività di vigilanza e monitoraggio. Aggiungiamo che, per come funziona il nostro cervello, il sistema riflessivo è dominato da una tendenza alla pigrizia, mentre la sua controparte automatica (quella che dovremmo tenere in disparte) è, al contrario, dichiaratamente interventista. Se la scelta è vivere o filosofare, sappiamo già come va a finire.

Dunque, non possiamo contare sulla nostra capacità di auto-monitoraggio. Una seconda notizia apre però qualche spiraglio ottimistico. Se siamo pessimi nel riconoscere i bias nel “nostro” comportamento, non siamo affatto male nel riconoscerli negli altri. Kahneman “sdogana” il buon vecchio pettegolezzo, in cui giudichiamo decisioni e opinioni degli altri alla macchinetta del caffè. Purché, sostiene, si tratti di pettegolezzo competente e informato. Purché quel singolo comportamento ci faccia ragionare su regolarità e indizi che si ripetono in condizioni più generali. Purché, in altre parole, conosciamo il nostro nemico.

Nell’improbabile caso che la nostra sopravvivenza dipendesse dallo smascheramento delle illusioni ottiche, non potremmo passare la vita con un righello in mano. Ma potremmo attraversare il mondo con un po’ più di serenità se solo ci ricordassimo di esserci già imbattuti nella Müller-Lyer. E se di quell’incontro ricordassimo quelle strane freccette orientate in modo opposto. E se il contesto suggerisse cautela (ad esempio la presenza di un signore in camice bianco che vi guarda e prende appunti). Conoscendo dunque l’illusione, e il contesto, e gli indizi (cue) che ne segnalano la possibile presenza. Allora sì che un supplemento di vigilanza, e il ricorso agli onerosi servigi del sistema riflessivo, potrebbero cavarci dall’impiccio.

Ecco dunque profilarsi una soluzione di compromesso. Impariamo a riconoscere le situazioni in cui gli errori sono probabili, e dedichiamo attenzione e sforzi di prevenzione dove i rischi sono particolarmente elevati.

Attraversiamo la nostra vita cognitiva come un campo minato. Il terreno è pieno di irregolarità: alcune di esse sono solo sconnessioni naturali, altre nascondono mine. A un primo sguardo è difficile distinguere le une dalle altre. Ma se osserviamo bene, e se siamo in tanti a scrutare, possiamo cominciare a riconoscere un dosso casuale da una montagnetta che nasconde il pericolo. E possiamo cominciare a disegnare una mappa che ci mette in guardia dalle zone più “tipiche” della presenza di mine, e di pericolo. Che ci aiuti a capire, nella traversata, dove dobbiamo aumentare la vigilanza; dove mettere i piedi con cautela, e dove invece possiamo camminare senza troppi patemi.

Quanto grande sarà questa mappa?

I bias attualmente censiti sono molte decine. Per quanto alcuni di essi siano raggruppabili per temi, o per meccanismi di base, molti sono miscellanei, o tra loro incorrelati. Le situazioni in cui potremmo incontrarli, innumerevoli. Se anche riuscissimo a costruire una mappa del genere, avremmo un pesante volumone da consultare a ogni piè sospinto.

Però, però…

Posto che tutti i bias costituiscono un pericolo, non comportano gli stessi rischi per chiunque. Né le occasioni in cui li si incontra sono le stesse. O egualmente pericolose. La loss aversion (che esprime la tendenza universale a soffrire una perdita in misura molto maggiore del piacere derivante da un equivalente guadagno) è rilevante, per un coach

- nelle modalità di comunicazione di una situazione ricca di luci e ombre;

- o nella comprensione della ferita provocata da un demansionamento.

Per un manager è molto più rilevante nel contesto di una negoziazione, dove peraltro è cruciale anche l’euristica dell’ancoraggio (la rilevanza del punto iniziale di una valutazione sul risultato finale), che non tormenta sicuramente il sonno di un coach. Professioni diverse percorrono alcuni tratti del campo minato in comune, ma anche molte traiettorie diverse tra loro. E gli stessi rischi hanno significati e impatti assai diversi tra loro.

Per quanto i bias siano gli stessi per tutti, ogni campo dovrebbe tracciare la sua mappa: con i suoi percorsi tipici, le sue istruzioni, i suoi segnali deboli, le sue criticità, le sue contromisure.

Forse è ora che anche i coach comincino a disegnare la loro.

Photo by Jennifer Griffin